Dirección

175 Greenwich St, New York, NY 10007

Dirección

175 Greenwich St, New York, NY 10007

Una nueva avalancha de material de abuso sexual infantil creado por inteligencia artificial amenaza con abrumar a las autoridades que ya están frenadas por tecnologías y leyes anticuadas, según un nuevo informe publicado el lunes por el Observatorio de Internet de la Universidad de Stanford.

Durante el año pasado, las nuevas tecnologías de inteligencia artificial han facilitado a los delincuentes la creación de imágenes explícitas de niños. Ahora, los investigadores de Stanford advierten que el Centro Nacional para Niños Desaparecidos y Explotados, una organización sin fines de lucro que actúa como agencia coordinadora central y recibe la mayor parte de su financiación del gobierno federal, no tiene los recursos para combatir la creciente amenaza.

CyberTipline de la organización, creada en 1998, es la cámara de compensación federal para todos los informes en línea de material de abuso sexual infantil, o CSAM, y es utilizada por las autoridades encargadas de hacer cumplir la ley para investigar delitos. Pero muchos de los consejos recibidos están incompletos o llenos de imprecisiones. Su pequeño equipo también ha tenido dificultades para mantener el volumen.

«Es casi seguro que en los próximos años CyberTipline se verá inundado de contenido de IA de apariencia muy realista, lo que hará aún más difícil para las autoridades identificar a niños reales que necesitan ser rescatados», dijo Shelby Grossman, uno de los autores del informe.

El Centro Nacional para Niños Desaparecidos y Explotados está en la primera línea de una nueva batalla contra las imágenes de explotación sexual creadas por IA, un área de delincuencia emergente que todavía están delineando los legisladores y las fuerzas del orden. En medio de una epidemia de desnudos falsos generados por IA que circulan en las escuelas, algunos legisladores están tomando medidas para garantizar que dicho contenido se considere ilegal.

Las imágenes CSAM generadas por IA son ilegales si contienen niños reales o si se utilizan imágenes de niños reales para entrenar datos, afirman los investigadores. Pero aquellos producidos sintéticamente y que no contienen imágenes reales podrían protegerse como libertad de expresión, según uno de los autores del informe.

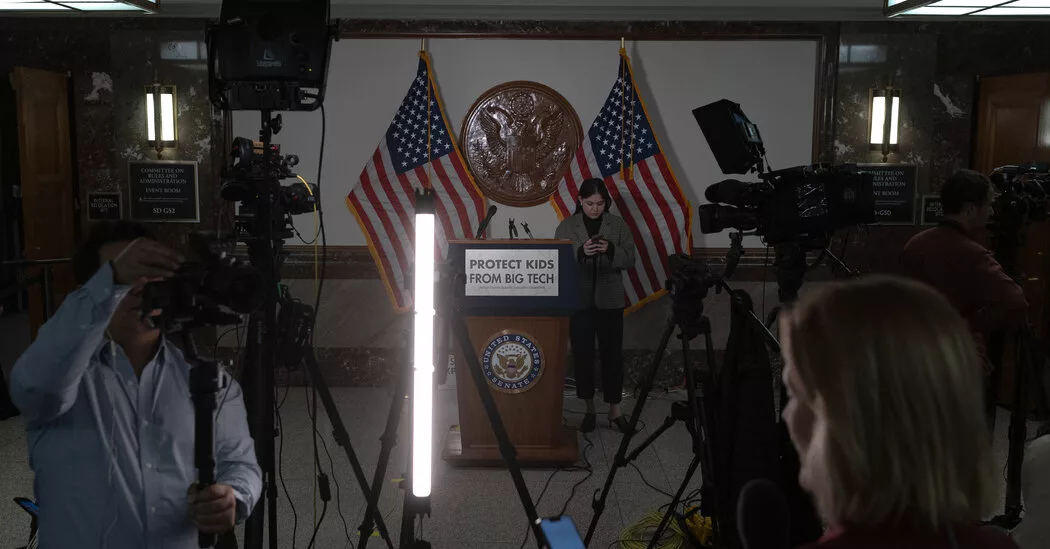

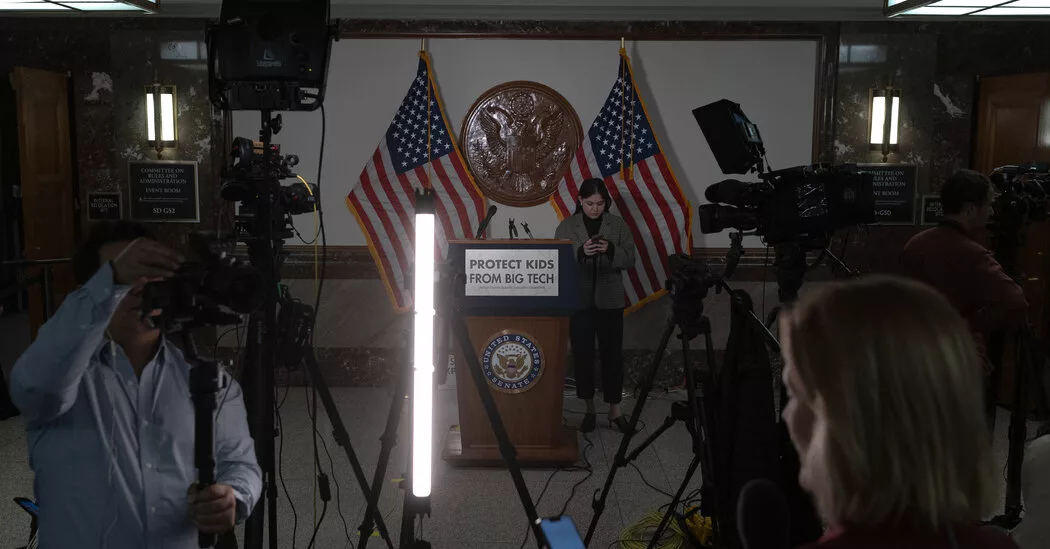

La indignación pública por la proliferación de imágenes en línea de abuso sexual infantil explotó en una audiencia reciente con los altos ejecutivos de Meta, Snap, TikTok, Discord y X, quienes fueron criticados por los legisladores por no hacer lo suficiente para proteger a los niños en línea.

El Centro para Niños Desaparecidos y Explotados, que recibe consejos de personas y empresas como Facebook y Google, ha abogado por una legislación para aumentar su financiación y darle acceso a más tecnología. Los investigadores de Stanford dijeron que la organización proporcionó acceso a entrevistas de los empleados y sus sistemas para que el informe pudiera mostrar vulnerabilidades en los sistemas que necesitan actualización.

«A lo largo de los años, la complejidad de la denuncia y la gravedad de los delitos contra niños siguen evolucionando», afirmó la organización en un comunicado. «Por lo tanto, aprovechar las soluciones tecnológicas emergentes a lo largo del proceso CyberTipline conduce a proteger a más niños y responsabilizar a los delincuentes».

Los investigadores de Stanford descubrieron que la organización necesitaba cambiar la forma en que funcionaba su línea de denuncia para garantizar que las fuerzas del orden pudieran determinar qué informes involucraban contenido generado por IA, así como garantizar que las empresas que informaban sobre material de posible abuso en sus plataformas completaran los formularios en su totalidad.

Menos de la mitad de todas las denuncias realizadas a CyberTipline fueron “procesables” en 2021, ya sea porque las empresas que denunciaron el abuso no proporcionaron suficiente información o porque la imagen de un informe se difundió rápidamente en línea y fue denunciada muchas veces. La línea de sugerencias tiene la opción de verificar si el contenido de la sugerencia es un meme potencial, pero muchos no la usan.

En un solo día a principios de este año, una cifra récord de un millón de informes de material de abuso sexual infantil inundó la cámara de compensación federal. Durante semanas, los investigadores trabajaron para responder a este aumento inusual. Resultó que muchos de los informes estaban relacionados con una imagen de un meme que la gente compartía en plataformas para expresar indignación, en lugar de intenciones maliciosas. Pero aun así consumió importantes recursos de investigación.

Esta tendencia empeorará a medida que se acelere el contenido generado por IA, dijo Alex Stamos, uno de los autores del informe de Stanford.

«Un millón de imágenes idénticas es bastante difícil, un millón de imágenes separadas creadas por IA las rompería», dijo Stamos.

El Centro para Niños Desaparecidos y Explotados y sus proveedores de servicios tienen prohibido utilizar proveedores de computación en la nube y deben almacenar imágenes localmente en las computadoras. Los investigadores descubrieron que este requisito dificulta la construcción y el uso del hardware especializado utilizado para crear y entrenar modelos de IA para sus investigaciones.

Por lo general, la organización no cuenta con la tecnología necesaria para utilizar ampliamente software de reconocimiento facial para identificar a las víctimas y a los perpetradores. Gran parte del procesamiento de informes sigue siendo manual.

MundoDaily – #material #sobre #abuso #sexual #infantil #generado #por #podría #abrumar #línea #denuncia

Publish: 2024-04-22 09:00:08